Estados Unidos no obligó a todos los países a desarmarse después de la Primera Guerra Mundial. Sin embargo, el Tratado de Versalles sí exigió que Alemania se desarmara, y las otras potencias centrales también debían reducir sus ejércitos.

Estados Unidos no obligó a todos los países a desarmarse después de la Primera Guerra Mundial. Sin embargo, el Tratado de Versalles sí exigió que Alemania se desarmara, y las otras potencias centrales también debían reducir sus ejércitos.

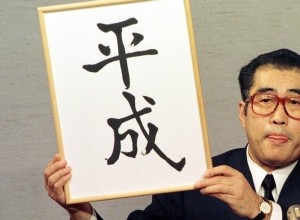

El 30 de abril de 2019 finalizará la era de Heisei que ha durado 30 años. No existe tal cambio en el nombre de la era, así que recordemos la era de Heisei en el último día de Heisei. 1989-1993 (1989-1993) 1994-1998 (1994-1998) 1999-2003 (1999-2003) 2004-2008 (2004-2008) 2009-2013 (2009-

![[Naohira Ii] ¡El bisabuelo de Naotora, la Dama del Castillo! ¿Parientes cercanos a Ieyasu Tokugawa?](https://www.historyback.com/article/uploadfiles/202207/2022072209261974_S.jpg)

2017 Taiga Lady Lord Naotora ( Naotora ) .. Es la historia de Naotora Ii, quien trabaja duro para proteger el declive de la familia Ii. El bisabuelo de Naotora, Naohira Ii ( Buena palma ) san . La familia Ii estaba bajo el control del Sr. Imagawa. También conoció la

Arquitectura Védica Hay docenas de textos antiguos de arquitectura en el mundo y esos textos están sólo en sánscrito, por lo que son herencia de la civilización védica. Los textos sánscritos en los que se encuentran los detalles de la arquitectura védica, es decir, la arquitectura y todo el método

La vida de Balban está llena de peleas y disturbios. Era un brutal asesino de humanos. Mató a un lakh de seres humanos para reprimir la voz de protesta que se alzaba una y otra vez en Delhi. En todas las ciudades se amontonaban cadáveres cuya podredumbre impregnaba toda la atmósfera de un olor insop