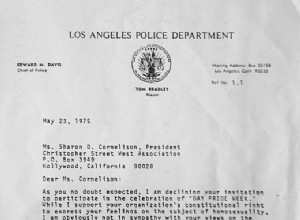

En mayo de 1975, Edward Davis , el entonces jefe de policía de Los Ángeles (California), fue invitado a participar en el desfile de LA PRIDE -la celebración anual de la comunidad LGBT comunidad (Lesbianas, Gays, Bisexuales y Transgénero ) que tuvo lugar por primera vez en 1970-. Davis, en su respues