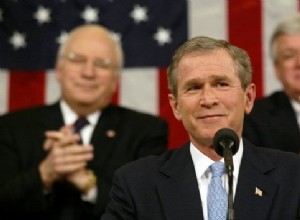

La doctrina Bush fue una directriz de política exterior estadounidense establecida por el presidente estadounidense George W. Bush en 2002. Esta ideología favorecía la guerra preventiva, la lucha contra el terrorismo y la libre circulación de capitales. También declaró a tres países miembros del E