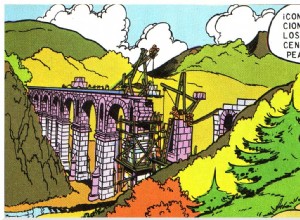

Dos plantas altas, incluso varias habitaciones y trescientos ochenta metros cuadrados de espacio. Si no fuera por los problemas de luz natural típicos de una mansión de esta época, ni siquiera los millonarios de hoy despreciarían una casa así. Es muy posible que este milagro arquitectónico se constr